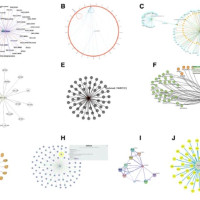

Publications of Andreas Holzinger, Human-Centered AI > Scholar, DBLP, ORCID, SCI

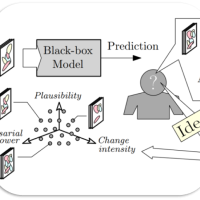

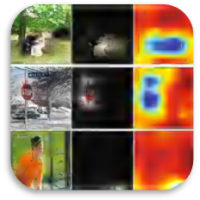

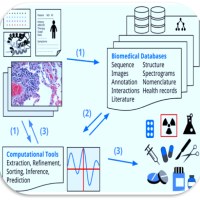

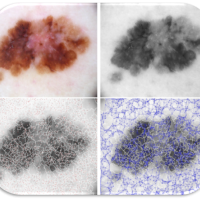

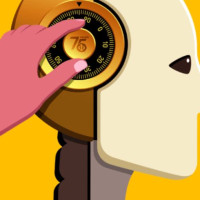

The introduction of artificial intelligence (AI) in domains that affect human life (agriculture, climate, forestry, health, …) has led to an increased demand for trustworthy AI. Andreas Holzinger works with his group on Human-Centered AI (HCAI) and multimodal Causability *) motivated by the desire to improve robustness and explainability in order to foster trustworthy AI solutions. Andreas promotes a synergistic approach to enable the human-in-control and align AI with human values, ethical principles and legal requirements to ensure privacy, security, and safety. Large Language Models (such as Chat-GPT) show impressivly how important the question remains “Can I trust the results?”

Subject: Computer Science (102) > Artificial Intelligence (102 001)

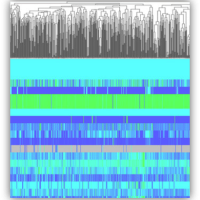

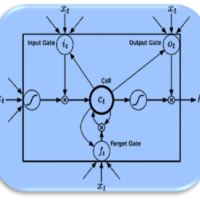

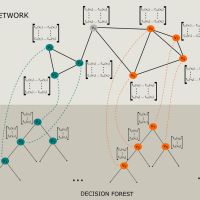

Technical Area: Machine Learning (102 019)

Keywords: Human-Centered AI (HCAI), Explainable AI (XAI), interactive Machine Learning (iML), Decision Support, trusthworthy AI

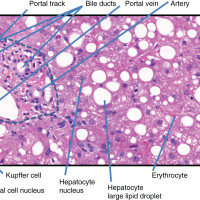

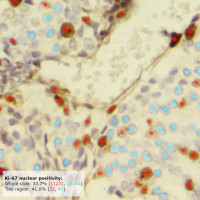

Application Areas: Domains that impact human life (agriculture, climate, forestry, health, …)

United Nations Sustainability Goals (SDG): 2, 3, 12, 13, 15 (see research plan: https://doi.org/10.3390/s22083043)

ORCID-ID: http://orcid.org/0000-0002-6786-5194

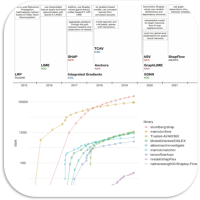

Publication metrics as of December 2024

Google Scholar citations: 30,232, Google Scholar h-Index = 85

Scopus h-Index = 58, Scopus citations = 14,311

Web of Science (Clarivate Science Citation Index SCI – formerly publons) = 50, WoS citations 9,188

DBLP Peer-reviewed conference papers c = 208, Peer-reviewed journal papers j = 123

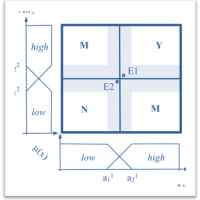

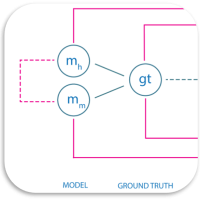

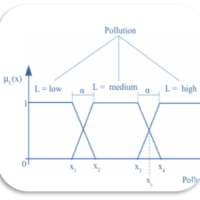

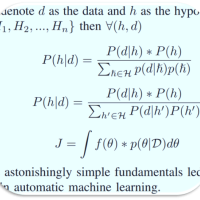

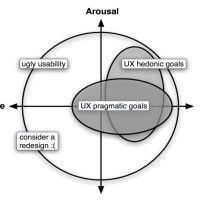

*) N.B. Causability is neither a typo nor a synonym for Causality in the sense of Judea Pearl. We introduced the term Causa-bil-ity in reference to Usa-bil-ity. While XAI is about implementing transparency and traceability, Causability is about the measurement of the quality of explanations, i.e. the measurable extent to which an explanation of a statement to a user achieves a specified level of causal understanding with effectiveness, efficiency and satisfaction in a specified context of use.

- Explainability := technically highlights decision relevant parts of machine representations and machine models i.e., parts which contributed to model accuracy in training, or to a specific prediction. It does NOT refer to a human model !

- Causality : = relationship between cause and effect in the sense of Pearl

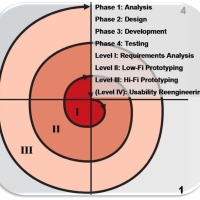

- Usability := according to DIN EN ISO 9241-11 is the measurable extent to which a software can be used by specified users to achieve specified goals with effectiveness, efficiency, and satisfaction in a specified context of use, see Holzinger

- Causability := the measureable extent to which an explanation to a human achieves a specified level of causal understanding, see Holzinger) It does refer to a human model !

Successful mapping between Explainability and Causability requires new human-AI interfaces which allow a contextual understanding and let domain expert ask questions and counterfactuals (“what-if” questions). Critics of this approach continue to ask the question what the human-in-the-loop should do; my concrete answer: The human-in-the-loop can (sometimes – not always) bring in human experience and conceptual knowledge into AI processes – something that the best AI algorithms on this planet are still lacking.

N.B. Causability ist weder ein Tippfehler noch ein Synonym für Causality im Sinne von Judea Pearl. Wir haben den Begriff Causa-bil-ity in Anlehnung an Usa-bil-ity eingeführt. Während es bei XAI um die Umsetzung von Transparenz und Nachvollziehbarkeit geht, geht es bei Causability um die Messung der Qualität von Erklärungen.

- Explainability := hebt technisch entscheidungsrelevante Teile von Maschinendarstellungen und Maschinenmodellen hervor, d.h. Teile, die zur Modellgenauigkeit im Training oder zu einer bestimmten Vorhersage beigetragen haben. Sie bezieht sich nicht auf ein menschliches Modell!

- Usability := (“Gebrauchstauglichkeit”) nach DIN EN ISO 9241-11 ist das messbare Ausmaß, in dem ein System für einen Benutzer ein spezifiziertes Niveau der Benutzbarkeit mit Effektivität, Effizienz und Zufriedenheit in einem spezifizierten Nutzungskontext erreicht, siehe Holzinger

- Causality := Beziehung von Ursache und Wirkung im Sinne von Pearl

- Causability := (“Ursachenerkennbarkeit” – in Erweiterung zu “Ursachentauglichkeit”) ist das messbare Ausmaß, in dem eine Erklärung einer Aussage für einen Benutzer (das menschliche Modell !) ein spezifiziertes Niveau des kausalen Verständnisses mit Effektivität, Effizienz und Zufriedenheit in einem spezifizierten Nutzungskontext erreicht, siehe Holzinger

Dies erfordert neue Mensch-KI-Schnittstellen, die ein kontextuelles Verständnis ermöglichen und es dem Domänenexperten erlauben, Fragen und Counterfactuals (“Was-wäre-wenn”-Fragen) zu stellen. Kritiker dieses Ansatzes stellen stets die Frage, was der Human-in-the-Loop tun soll; meine konkrete Antwort: Der Human-in-the-Loop kann (manchmal – natürlich nicht immer) menschliche Erfahrung und konzeptionelles Wissen in KI-Prozesse einbringen – etwas, das den besten KI-Algorithmen auf diesem Planeten (noch) fehlt.